Un viaggio alla scoperta delle previsioni del tempo e dei modelli meteorologici. Cosa si cela dietro le mappe con i simboli di sole, pioggia, neve e vento? Scopriamo i segreti di una scienza tanto complessa, quanto affascinante

di Andrea Bonina – © MeteoBronte

1. COME SI SUDDIVIDONO LE PREVISIONI METEO

In base alla distanza temporale tra l’emissione della previsione ed il range di riferimento distinguiamo:

- Nowcasting (meno di 24 ore – Elevata attendibilità)

- Previsione a breve termine (24-72 ore – Buona attendibilità)

- Previsione a medio termine (meno di una settimana – Discreta attendibilità)

- Previsione a lungo termine (da una a due settimane – Bassa attendibilità)

- Previsioni stagionali (sulla base di modelli sperimentali – Attendibilità molto bassa)

Fatta questa indispensabile premessa, che denota come anche a pochissime ore ci siano margini di errore, seppure mediamente bassi, andiamo ad esplorare i meandri dei modelli fisico-matematici, che studiano un sistema CAOTICO e non lineare (cioè ad andamento non costante o definibile da una legge fissa) come l’atmosfera.

2. I MODELLI FISICO-MATEMATICI: COSA SONO ED A COSA SERVONO

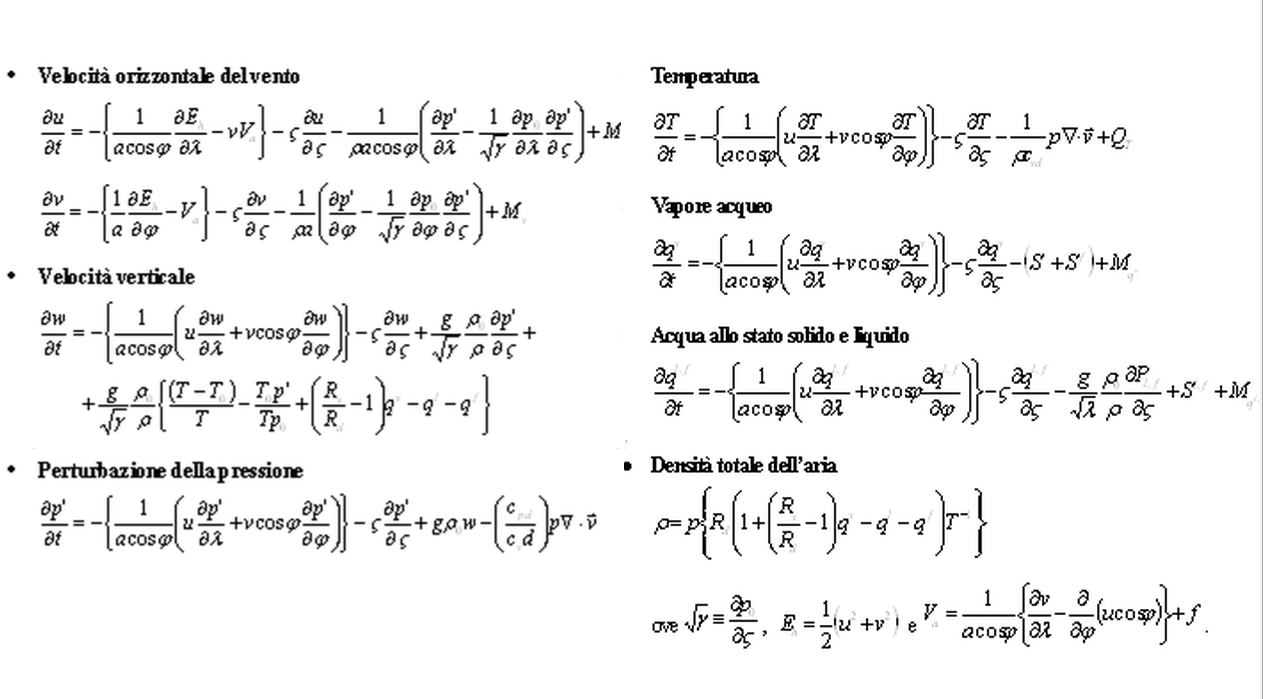

I modelli fisico-matematici schematizzano e simulano il comportamento dell’atmosfera attraverso l’utilizzo della fisica teorica, della matematica e di dati reali strumentali. Rappresentano la base delle previsioni del tempo. Lo stato dell’atmosfera è definito dalla distribuzione spaziale di vento, temperatura, pressione e diverse altre variabili. La loro evoluzione temporale è descritta da un insieme di equazioni differenziali che rappresentano i processi fisico-dinamici agenti nell’atmosfera; esse sono derivate applicando le leggi della conservazione della massa, del moto, della quantità di calore, dell’acqua e di altri gas ed aerosol. Un modello numerico è dunque una rappresentazione matematica dei processi dinamici, fisici e chimici agenti nell’atmosfera. Tipicamente l’atmosfera è rappresentata tramite una griglia tridimensionale con vari livelli verticali, dove vengono integrate le equazioni. I valori iniziali delle variabili atmosferiche da specificare su ogni punto della griglia sono ottenute tramite complesse procedure che fanno uso delle osservazioni. La soluzione del sistema di equazioni richiede la conoscenza delle condizioni iniziali. La cartografia finale, con relativi parametri e scale cromatiche, è il risultato di output del complesso schema di calcolo.

3. SISTEMI DI RILEVAZIONE DEI DATI METEO E RELATIVI PROBLEMI

L’ Organizzazione Meteorologica Mondiale dispone di una rete strumentale, rigorosamente a norma ed esposta a periodici controlli, costituita da migliaia di stazioni meteorologiche, palloni sonda, satelliti, boe e radiometri, oltre che dai più recenti sistemi radar. Tali strumentazioni concorrono alla “strutturazione” delle 7 variabili indispensabili, definite condizioni iniziali del sistema, fondamentali nell’ambito del calcolo dei modelli matematici. Esse sono:

1. Temperatura dell’aria

2. Umidità atmosferica

3. Pressione atmosferica

4. Radiazione solare

5. – 6. – 7. Le tre componenti verticali del vento (vettoriali)

I. Errori sistematici

Nel computo dei dati meteorologici fondamentali (vedi paragrafo precedente) il rischio è quello di errori sistematici (e non) relativi alle rilevazioni. Una stazione meteorologica imprecisa, boe in momentanea avaria, improvvisi difetti dei sensori ed errori simili concatenati, non dipendenti dall’uomo ma dai limiti strumentali, sono il primo scoglio da affrontare nell’ambito del caotico mondo delle previsioni del tempo. Una fallace ricostruzione delle condizioni iniziali si ripercuoterà severamente in sede di calcolo.

II. La densità di dati di una determinata area e la necessità di approssimazioni

Per un’inizializzazione quanto più veritiera e con errori quanto più ridotti, l’ideale sarebbe un’omogeneità di dati da tutti gli angoli del globo, dall’Italia all’Australia, dai Poli all’Equatore, con maglie equispaziate e relativi ai vari livelli della troposfera, dal suolo alle alte quote. E’ così? Chiaramente no. Esistono delle aree della Terra quasi del tutto “scoperte” dal monitoraggio delle condizioni atmosferiche, come gran parte del continente africano e dell’Antartide. Se considerassimo l’intera superficie della Terra, la copertura di dati puntuali dalle stazioni meteorologiche sarebbe addirittura inferiore all’1%; se considerassimo, invece, un diametro di 50 km per ogni stazione meteo (raggio di circa 25 km attorno ad ogni centralina) la copertura di dati sarebbe comunque inferiore al 50%. Se si utilizza, invece, una griglia di 50km che copre tutta la Terra, il 60% della superficie in Europa e l’8% della superficie in Africa sono coperte da misure. In nostro soccorso giungono le telerilevazioni satellitari, annoverate tra le misurazioni indirette, che analizzano la radiazione elettromagnetica in emissione e ci permettono, pur se in modo non particolarmente preciso, di stimare, ad esempio, la temperatura nei vari livelli atmosferici. Per compensare parzialmente l’assenza di dati diretti si ricorre ad approssimazioni tramite complesse tecniche. Per avere una conoscenza iniziale più accurata del sistema atmosferico, si estrapola un campo grezzo, detto di First Guess, da quello che il modello numerico aveva previsto dalle sei alle dodici ore prima e, successivamente, si corregge questo campo con tutte le osservazioni, convenzionali e non, misurate in un intorno dell’ora di analisi, entro un cut-off time massimo stabilito dal centro operativo di calcolo. Va da sé che un dato calcolato, non originato da un’osservazione diretta, approssima più o meno bene la realtà, ma non la rappresenta perfettamente. Banalmente, ipotizziamo di conoscere i dati meteo di Catania centro ad una certa ora, rilevati da una rete di 5 stazioni meteorologiche a norma e di voler ricavare a partire da essi quelli di Palermo. Attraverso particolari algoritmi riusciremo a risalire, grossomodo, alla situazione del capoluogo di regione, ma con un determinato scarto dalla realtà frutto di microclima, orografia ed una serie numerossissima di altri fattori a scala locale. Estendete questo concetto ad ampie fette del pianeta, ben più remote, e pensate a quanto sia approssimata ed “inesatta” la rappresentazione dello stato inziale dell’atmosfera da cui parte il calcolo modellistico. La natura caotica e non lineare del sistema “non perdona” ed amplifica esponenzialmente gli errori in sede di calcolo: l’atmosfera, pertanto, diventa sempre più imprevedibile quanto più ci spingiamo in avanti nella previsione.

III. Enorme mole di dati. Le tempistiche di calcolo tramite supercomputer

Da quanto precedentemente visto, dunque, un deficit di dati diretti può comportare un notevole peggioramento delle prestazioni modellistiche e della qualità delle previsioni. Una sovrabbondanza di dati inseriti nei modelli matematici, di contro, comporterebbe tempi di calcolo eccezionalmente lunghi, nonostante le più innovative tecnologie a nostra disposizione: estremizzando il concetto, malgrado i supercalcolatori in uso – capaci di svolgere oltre 250 miliardi di operazioni al secondo – faremmo prima a guardare il tempo affacciandoci dalla finestra, anziché aspettare la fine dei calcoli modellistici! Vale dunque il detto “in medio stat virtus”: i dati devono essere omogenei ma non eccesivamente numerosi. Solitamente si opta per 2, 4 o più “run” al giorno, generalmente alle 00, 06, 12 e 18 UTC: così facendo si dispone di previsioni sempre aggiornate poiché inizializzate più volte al giorno con nuovi dati; le corse del modello, distanziate di 6 o 12 ore, inoltre possono essere confrontate e verificate.

Invia una risposta